异构算力开源社区HAMi举办首届沙龙,将发布新版本,效能全面提升

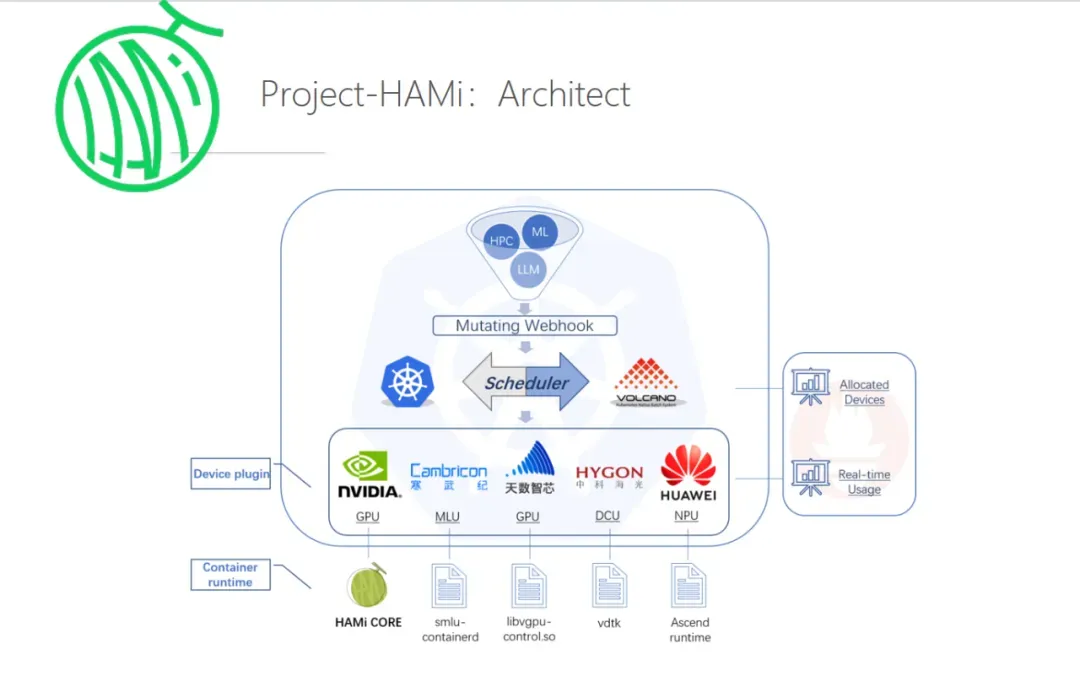

近日,AI异构算力开源社区 HAMi 首届线下沙龙成功举办,并宣布将于25年1月正式发布 HAMi 2.5.0版本。新版本将支持mig、mps等多种算力切分模式,并优化 WebUI 管理能力及易用性。HAMi 是基于第四范式 vGPU 等异构算力技术打造,并与道客、睿思智联联合发起的一款异构算力管理开源工具,实现对硬件集群平台化管理、算力资源共享、按需分配和快速调度,可有效提升 AI 算力资源利用率和计算执行速度,最多可节省 80% 硬件成本,提升 5-10 倍GPU综合利用率。

HAMi 主要功能包括:

● 主流算力部署及管理:全面适配国产/非国产算力,支持英伟达、华为昇腾、海光、寒武纪、天数智芯、沐曦、摩尔线程等不同类型算力集群的混合部署、统一调度和管理,并助力应用环境的国产化平稳逐步替代。

● 算力高效复用:通过虚拟化技术,实现“一卡多用”,即多个任务能够共享同一张显卡,通过算力资源的高效复用,提升硬件利用率,降低算力成本。

● 精细化资源管理:以设定的显存值或按比例分配GPU资源,确保任务使用的显存资源不会超过分配数值,满足企业对算力资源的精细化管理需求。算力切分精细至1%,显存切分以M兆为单位。此外,可根据设备类型与应用负载灵活调配资源配置,确保高优先级业务得到稳定资源。

目前,HAMi 已在云厂商、大型数据中心等超40家企业中应用。此次沙龙中,科大讯飞也作为资深用户代表,分享了 HAMi 在科大讯飞星辰 MaaS 平台中的应用实践:我们利用 HAMi 的 GPU 虚拟化和池化能力,在 AI 训练及微调等多场景中实现了大规模任务的灵活调度,并大幅提高了异构算力资源利用率,解决了任务高峰期的算力瓶颈问题。

HAMi 开源半年来,Github 下载量已突破15万次,吸引了来自华为、SAP、星环科技、道客等多家企业的开发者参与社区贡献,实现了与 Volcano 等多个知名社区项目的无缝集成。与此同时,在开发者及开源社区的大力支持下,HAMi 接连成为 CNCF Landscape 及 Sandbox 代表项目,相关技术成果被 KubeCon 2024 Euro和 KubeCon 2024 HK收录。

责任编辑:kj005

文章投诉热线:157 3889 8464 投诉邮箱:7983347 16@qq.com