下一代人工智能的发展将如何发展?神经网络技术是机器学习的核心技术

在后摩尔时代下,我国的计算相关行业对于人工智能、大数据应用中的关键性数学问题和芯片技术的发展,有着更迫切、更紧迫的需求。

新兴的集成电路技术面临着哪些机遇和调整?后摩尔时代下的计算机系统结构如何?下一代人工智能的发展将如何发展?人工智能应用的落地与开放情况如何?

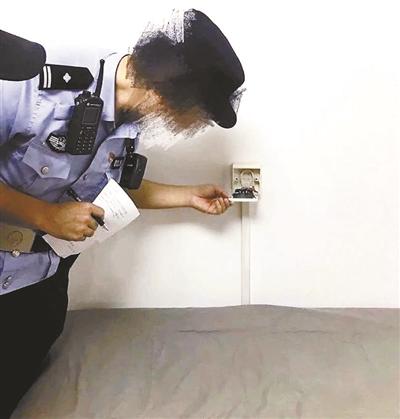

1月10日,由首都师范大学交叉科学研究院与计算机学会(CCF)集成电路设计专业组联合主办、CCF 集成电路设计专业组教育工作组协办的京区青年学者“后摩尔时期的计算形态与设计自动化”论坛在线上举办。来自北京大学、中国科学院、北京航空航天大学、清华大学、首都师范大学的专家、学者共同探讨了后摩尔时期,计算形态与设计自动化将何去何从?

存内计算是缓解瓶颈的有效途径之一

在北京大学信息科学技术学院长聘副教授、高能效计算与应用中心任副主任罗国杰看来,基于RRAM等新型非易失性存储的存内计算是解决冯诺伊曼瓶颈的可行途径。“面向存内计算的自动综合和映射技术。针对RRAM状态逻辑的综合流程,设计高面积利用率的自动化综合流程,通过减少原始输入和中间变量带来的面积开销,流程相对已有工作提高33%的面积利用率和1.43倍的吞吐量。”罗国杰说。

人工智能时代对计算能力以及效率的需求大大提高,传统的基于存储分层的计算机体系结构在处理大数据应用时呈现出计算访存比低、缓存命中率低的特点,也就是常说的“冯诺依曼瓶颈”。为了缓解“冯诺依曼瓶颈”,新型计算机架构 “存内计算”或者说“存算一体”将计算与存储在空间上合二为一,有效减少了数据通信带来的能量消耗。对此,北京大学人工智能研究院的助理教授燕博南认为,新兴非易失存储器(比如忆阻器)更是能够便捷地实现存内计算处理器。

“现有的存算一体电路和架构多数都是专用设计,缺乏通用性。”中国科学院计算技术研究所副研究员陈晓明说,其课题组在提高存算一体通用性方面,利用新型非易失器件能同时实现存储单元和开关单元的器件级特性,构建功能可配置的存算一体电路和架构,从而对不同的应用,可以更灵活地进行存算资源的配置。

使用开源软件对教学科研有重要意义

当前,知识产权保护在全球范围内受到广泛重视。然而,很多时候,一些跨国科技企业会利用技术先发优势来追求更高的垄断利润,从而阻碍技术创新。为了平衡知识产权保护和技术创新,上世纪80年代IT界开始了轰轰烈烈的自由软件运动。

“近年来,开源理念逐渐覆盖硬件领域。使用开源EDA软件的开源芯片设计对于计算机硬件领域的教学科研工作有着重要意义。”中国科学院大学教授沈海华说。

“以‘后摩尔时期’芯片设计教育为背景,以计算机系统能力培养为出发点,中国科学院大学本科生‘计算机组成原理’课程以及‘一生一芯’计划探索出了开源处理器敏捷开发验证环境平台、实践教学方法,取得了显著的教学效果。”中国科学院计算技术研究所高级工程师张科介绍。

神经网络技术是机器学习的核心技术

近年来,图神经网络方法在金融欺诈检测问题上取得了显著进展。“针对金融欺诈检测中的类别不平衡问题,专门针对类别不平衡问题设计的图神经网络具有更优效果。但其更为复杂的计算会导致在大规模金融行为图上的计算效率低下。我们期待对图神经网络加速的硬件技术的出现。”中国科学院计算技术研究所副研究员敖翔说。

北京航空航天大学计算机学院副教授杨建磊对他们“稀疏神经网络训练加速技术研究”方面开展的工作进行了分享。

随着5G通信与物联网技术的成熟,智联网(AIoT) 时代即将来临。“在未来 AIoT场景中强大的云端能力将虚拟化下沉到终端,边缘终端设备将呈现爆发式增长。边缘计算能够有效解决由以云为中心的计算引起的大量数据传输和隐私问题,然而日益复杂的神经网络给计算能力和能源受限的边缘设备带来了新的挑战,如何实现高能效神经网络计算架构成为学术界和工业界关注的热点问题。卷积神经网络CNN和递归神经网络RNN是边缘设备上机器学习应用的核心技术。”首都师范大学信息工程学院科研副院长、研究员王晶说。

当日,论坛邀请到的12位专家分别进行了报告线上直播观看论坛的观众人数的达到论坛还围绕着“新兴集成电路技术的机遇和调整”、“人工智能应用的落地与开放情况”、“新兴融合计算智能架构及软硬件协同设计”、“智能芯片及系统设计与实践”四个主题进行了报告和学术分享。线上直播观看论坛的观众人数的达到1100多人,参加会议的学者达51人。论坛受到业界学者的关注,杜克大学的陈怡然教授等学者在线上与演讲嘉宾讨论。

专家表示,论坛为不同学科领域的学者搭建了交流平台,加强了信息、数理以及计算机等多学科学者的沟通。“论坛报告人的报告体现了后摩尔时期的计算形态将以交叉融合的方式进行演进:器件、架构和应用算法之间的交叉融合;基础数学、计算机、材料等多学科的交叉融合;教育、科学研究和产业实践之间的交叉融合。”首都师范大学交叉科学研究院副研究员李冰说。(记者 马爱平)

责任编辑:kj005

文章投诉热线:156 0057 2229 投诉邮箱:29132 36@qq.com