GAITC智能传媒专题|曾文军:生成式人工智能是新型生产力

6月23日,由中国人工智能学会主办,CAAI智能传媒专业委员会、中国传媒大学数据科学与智能媒体学院、媒体融合与传播国家重点实验室、新浪新闻承办的主题为“变量激荡 增量涌现”2024全球人工智能技术大会 智能传媒专题活动在杭州拉开帷幕。加拿大工程院外籍院士、宁波东方理工大学(暂名)科研副校长、讲席教授、lEEE Fellow曾文军分享了题为《可解释可控制AI内容生成》的演讲。

曾文军主题演讲中。

以下是曾文军演讲实录,内容经编辑略有删减:

感谢组委会的邀请,今天很高兴有这个机会,在这里基于我的团队前几年的一些工作,给大家分享一下我们对可解释、可控制的AI内容生成的一些认知和理解。

大家知道,人工智能自从1956年概念提出来之后,其发展是几起几落的。最近这十几年的发展,特别是近几年生成式大模型的发展,使我们看到了通用人工智能的一些希望。

生成式人工智能是通过机器学习,从数据中学习它的特征,进而生成全新的、原创的数据。从著名的Gartner技术成熟度曲线上可以看到,它最近处在非常高速发展的阶段。

生成式人工智能可以生成各种模态的内容:语言、语音、图像、代码等等。我们可以进行内容开发、内容生成和传媒方面的应用,也可以为我们的科学研究提供一些知识的参考。

Open AI的ChatGPT大家都非常熟了,它可以回答问题,生成文本、翻译等,也是Open AI希望达到实现通用人工智能目标的一个重要步骤。

目前一些人工智能大模型,在很多任务上已经可以通过图灵测试了,也就是它的能力是非常强的。其在很多方面引起了变革,微软对Open AI很早就开始有投入,所以现在整个产品线都围绕着它在发展。比如对于搜索可能是最大的一个冲击,所以百度、谷歌压力也非常大。微软从去年、前年开始,就已经把Open AI的大模型和搜索引擎深度结合了,所以有了现在的New Bing。当时发布的时候引起了一些大的反响,股票一夜暴涨了800亿美元,在市场份额中提升了一两个百分点。

微软在全盘拥抱大模型,把Open AI的GPT系列和它的办公室软件深度融合,所有的产品线,包括研究,都在围绕着大模型在开展。所以可以看到有些它的产品,像PPT能力等能够得到很大的提升。

在编程方面,因为微软有GitHub,拥有很多数据,这方面有大模型的加持,可以比较快地编程,可以减轻一些代价的代码。

在科学研究方面,我们有一些领域的大模型,包括在医疗方面、生物医学方面、化学方面,对研究的发展也起到了很大的作用。

在创造力方面,在内容生成方面,都有它的创新性。

在数字人方面,我们团队最近也有一些工作,比如在视频里面如何生成人人交互,就是有一个主动人做一个动作,另外一个人反应的动作序列是怎么样的,可以通过生成式人工智能的方式,对数字人的制作也可能有一定的作用。

我们因此也发布了目前最大规模的人人交互3D动作数据集,可以用来做motion to text,还有reaction motion generation,就是反应式动作生成等。

但是去年比尔·盖茨说了,生成式AI已成过去,已经达到峰顶了,未来应该是可解释AI的天下。所以他认为,我们在通往通用人工智能方面还有很多工作需要做。

什么叫可解释人工智能?它指的是AI的行为可以被人类理解,它与深度学习中的“黑匣子”概念形成一个鲜明对比,“黑匣子”完全是数据驱动的,所以有时候我们不知道里头发生了什么事情。我们希望可解释AI至少对模型的运行机理能够有比较好的解释。

这方面的工作可以分成三大类,一类是在建模前我们对数据做一些可解释的分析,通过可视化数据,对数据有一定的理解。还有一类是构建可解释性的模型,也就是模型本身希望它有一定的解释性,我们知道它是如何工作的,我们得到的一些结果也知道它是如何产生的。还有一种,也有一些前期工作,就是模型先建,然后对模型进行可解释性分析,去理解这个模型怎么做的。这个应该控制性稍微小一点,模型本身可能有可解释性,可能也没有,我们只是对它做一个事后分析。

从最近这几年关于可解释性AI文章数量也可以看出,它越来越受到大家的关注,当然大家用词可能不一样,但其实都是这个意思,希望我们对于模型或者是数据或者是功能方面有一定的解释性。

生成式AI还是面临一些挑战的,它有一定的问题,比如在谷歌Bard发布的时候,产生了一些用词是不真实的,不符合事实的,它的代价也很大,所以两天市值蒸发了1500亿美元,大家对大模型本身的能力有一定的质疑,对于它的应用有一定的质疑。

同样,ChatGPT也有幻觉的问题,比如它曾经发布一个丑闻,里面指认了实际的一个人作为一个被告,还引用了一些虚构的文章。这种现象,大家不理解它为什么会产生这种文章,也许因为它就是基于概率的。所以这方面让大家产生很多困惑,就是我们怎么对待大模型产生的一些内容。我们对它的机理,如何产生这些内容没有更好的理解。

大语言模型能力非常强,它与我们大脑运作在很高层次上是比较接近的,比如人脑是与环境交互进行强化学习,大模型也用了人类反馈的强化学习的机制。我们人脑有法律和道德的约束,在大模型上我们试图去增加一些警示,增加一些规章制度,避免它产生一些不太合适的内容。但是大模型确确实实太大了,所以它里面的参数含义也很难理解,完全控制它的输出几乎是不太可能的,有时候我们不理解它为什么产生这些内容。

在文生视频方面Open AI 的Sora的能力非常强了,它的真实感非常强,对我们的提示词的表达也比较逼真,它有比较强大的能力,但同样这种大模型也存在内容生成方面不太可理解的问题。

Sora技术背景是利用了Transformer能力,再加上和扩散模型的结合,能够产生一个高质量的逼真视频。Sora也存在反事实生成等一些问题。比如这个杯子倒了,但是它表现出来的跟自然规律不太一样,也就是它不太理解这个杯子的水倒了的物理原理是什么。同样,在跑步机上跑步,看起来也不太符合逻辑,背着跑步机在跑。也就是说,它能够产生一定的内容,但是对一些后面的物理原理、机理的东西还不太理解。包括吹蜡烛,吹了以后这个火焰也没有反应等等,还是缺少对我们物理原理的认知。

所以生成式AI面临着安全方面的挑战,有几方面:一个是数据安全,数据的隐私、数据的质量本身也是一个问题,里面的数据可能还有一些偏见;二是模型方面,模型的可解释性是非常有限的,模型本身也会受到一些攻击,也可能带有一些数据的偏见;三是内容生成方面,可以看到虚假的信息,不真实的信息,准确性问题等等。

Open AI的CEO自己也说了,在这个阶段,不能够依赖ChatGPT去做任何重要的事情。也就是说它不太可靠,你让它去做一些医疗、工业生产等后果严重的事,还要比较小心,因为可解释性方面还是有一定的局限性。

因为前期技术发展,大家比较重视它的性能、质量,忽视了对它的可解释性,这方面工作相对来说少一点。最近学术上有一些工作,国家层面上也有这方面的一些投入,比如美国就有一个NSF/NDIF项目,就是希望对大模型本身各个部件的机理有一个更好地理解,每个部件到底是做什么事情,通过探究型的形式,对各个不同的部件进行放大、理解。

这也说明我们存在一个问题,这是一个挑战,也是一个机会,从学术角度来讲,我们怎么去解决这些问题? 有不同的方法,我今天在这里关注的是我们认为比较有前途、有意义的方向,叫表征解耦,这个概念是Bengio 2013年提出来的,他说如果想让AI能根本性地理解我们的世界,必须将隐藏在数据背后的可解释的factor解耦出来。什么意思呢?

这是些图像,这些图像后面可解释的因素是什么?是它的物体的形状、颜色、大小,包括相机的角度等等,这是产生这个图像的基本概念或者是我们对这个图像的一个理解。

这些是在数据背后的可解释因素,如果我们做到对这些因素的表征解耦,我们在生成的时候,可以通过独立地调整这个参数生成一系列图像,只有对应的属性是在变化的,其他属性不变。这就是我们对它有比较深的理解了,知道它是如何生成这些图像的。

同样,我们也希望给我这个图像,能够设计出AI模型,能够提取出比较独立的、比较可解释的因素。如果我们能够做到这点,我们对图像的理解以及它的生成就有比较好的可解释性,我们知道它是如何生成的,跟物理世界的契合度就比较高。

Bengio提出这么一个概念,但是他并没有提出解决方案。这个概念是非常重要的,它对可解释性,对后面做一些推理,对一些概念的学习,都有非常基础性的意义。

从应用的角度,我们今天在谈内容生成,实际上它对图像的生成、对图像的编辑,只改变某个属性,而不改变其他属性,都有很大的意义。你如果能够理解透了以后,就不需要那么多数据对新的场景做重复训练,因为它后面的本质是一样的。我个人认为比较重要的是泛化性的应用,因为我们现在面临工业应用领域很大的问题是泛化性。换了一个场景后,一个模型性能可能会下降很多,就是因为你对它的理解并不是很透,它完全是数据堆积起来的,如果它按照表征解耦的方式去理解这个物体,你换了一个环境,它可以清楚哪些是不变的因素,哪些是变的因素,它只要针对那些变的因素就行了,不变的因素它已经学得很好了,模型可以很快适应。所以,有了这个表征解耦之后,对于我们传媒领域应该有比较大的帮助。

这是2021年ICLR文章的统计,表征解耦已经是比较受关注的一个课题。下面举一些例子,什么叫表征解耦?我们怎么做?从解决方案角度来讲。

这是比较早期的一个解决方案,它是利用VAE网络结构,你有一个encoder,有一个decoder,它有一些不确定性,通过概率分布参数的表达,它的均值、方差,通过采样去做生成。这里面Loss方程有两项,第一项就是图像重建的质量,你这个图像分解了以后再重建应该尽量接近。所以第一项表示输入和输出要一样;第二项,在传统的VAE里,β是等于1,它实际是描述两个分布的差异,也就是说这个表征空间的表达Z,它的分布,我们觉得应该不错的是独立的联合高斯分布。所以希望在系统里面,分布跟独立的联合高斯分布是接近的,通过这种方式去约束它。但传统的VAE的方法,第一,它重视质量,它能重建得好;第二,它希望Z表征空间的分布有一定特性。但是我们现在关注的是表征解耦,我们就要更重视第二项,也就是它的元素是要独立的,因为这是一个必要条件。如果你想独立控制它,我们希望这些元素都是相互独立的。所以我就把β值加大,让它更注重、更关注这个,这样就能够保证表征空间上的元素独立性更强一点,所以这是一个基本思想。

但是也有工作提出,这个独立性只是一个必要条件,不是充分条件,实际上有很多可能的解是可以满足它是独立,但是它并不是解耦的。所以它指出来这个问题,就是你这么做是一个好的方向,但是简单这么做是不够的,不能完全解决这个问题。

实际上更大的一个问题,表征解耦从概念上大家都可以理解,但是从数学定义上,什么叫表征解耦?这个问题Bengio没有把它解决掉,只是提出一个概念问题。所以后来在这方面比较重要的一个工作,他用数学的方法来表达什么叫表征解耦,从这个角度来定义满足什么样的条件叫做表征解耦。一般来说给定一个图像,你对图像有一个描述,图像通过编码映射到表征空间Z,所以我们希望这个表征空间Z是可解耦的。这个基于群论的定义大概的意思是说,我们可以用群的方式表达对图像的操作,它可以分成几个子空间Gi。如果这个从W到 Z的映射f满足一定条件,即同样的行为G,比如改变颜色,我可以在W和Z上做,在哪里做没有关系,最后是一回事。满足了这个条件,如果Z空间也可以分解成几个子空间Zi,而且每个Zi只受到前面那个相应群Gi的影响,有一个对应的关系。如果能够满足这些条件,这个Z的表达就是解耦的,所以从数学的角度定义了什么叫表征解耦。

这个定义非常好,让我们从理论的角度有一个比较清晰的定义。但是这里的问题是这个定义是作用在W空间上,需要对图像进行标注描述,在实际应用中或优化中难度比较大,理想的情况下,我们希望不需要标注,只给图像,就想办法把它训练好。

VAE/GAN-based很好地把它结合在一块了,最后发现它们是很契合的。最主要的是通过前面的那个定义,你可以推导出三个主要的约束,第一个是对数据的约束,基本上是对应前面基于VAE的方法,即表征Z要独立,它只是必要条件,不是充分条件。根据这个理论的定义还有另外一个约束,什么意思呢?要满足那个理论的定义,我在对图像做变化的时候,比如对图像做一个上下翻转,需要通过先Encode,做一个相应变换,即改变Z的值,再做Decode,可以得到你想要的图像。还有一个约束是什么叫可解耦,也很简单,对于刚才提到的可解释因素,其实每一个都是非常基本的操作,任何操作都可以在里面进行组合,我要满足它可解耦,其中一个必要条件是我对先做哪一个操作没有关系,比如先变颜色,再变大小,会等价于我先变大小,再变颜色,不会改变最后形成图像的样子。所以很简单,你可以做基本操作1,再做基本操作2,也可以先做基本操作2,再做基本操作1,会得到同样的结果。所以这两个操作非常接近或者是完全一样,这就是我们对可解耦的理解,最后转换成的两个差异要很小。

通过这些额外约束,可以做到更好地解耦。这是一些评价解耦能力的参数,值越大越好。所以通过结合基于群论的定义以后,就可以把均值增大一些。更重要的是 通过这个解耦以后,解耦的确定性是更大的,原来的方案,因为它只是满足一个必要条件,所以它的解耦性能变化范围很大,有时候解耦,有时候不解耦了,所以它的解耦能力有很大的方差。

从生成图像也可以看出,原来的方案要改变车的转向,但同时车的颜色也在变,也就是说,颜色和转向这两个因素还是耦合在一块的,它并没有很好解耦。 但是通过我们的技术,改变转向并不会改变颜色,也就是说这些因素已经分开了。改变表征空间的一个因素,看它生成图像的变化,可以看出解耦性。

再举一个例子,我们前段时间做的一个工作。对于生成模型,我们训练的时候并没有专门做解耦,但是会发现里面有一定解耦性,某些特定隐参数变化,生成图像会沿着某一个属性在变化,它隐含了这种能力,但是这种能力有多强不好说,但是确实有这个能力。GAN等生成模型的好处是质量比较高。所以我们能不能利用生成模型图像高质量的能力,同时又使它能够有解耦的能力,这样可以解决解耦合生成质量的矛盾。所以这也是我们提的一个方法,也很简单,我们知道在隐空间,我们可以设定它的变化方向,好的方向可能对应某个属性的变化,如果这个方向是对的,确实对应某个属性,生成的图像别的不变,只有某个属性是在变化的。再加了Encoder,前后输出差别会有一定规律,因为只有一个属性变,别的属性不变。如果方向不是对应某个属性的,是混杂的、耦合的方向,前后生成的图像就会比较乱,它不是只是某个属性变化,输出差别分布会很不一样。你可以用对比学习的方法,如果一致就有一个分布,不是一致它的分布不一样。可以同时训练这个隐空间方向搜索和解耦Encoder这样做,我们希望它重建的图像质量比较高,同时它又达到解耦的特性。

再举一个例子,也是我们最近的工作,用到VAE结构,我们希望训练出一个表达空间,它是解耦的。但是我们可以借助于扩散大模型的强大能力,我们知道扩散模型里图像生成是一个迭代的过程,它有不同质量的生成,这样闭环交互训练、互相辅助。比如这里生成解耦的表征结果,去控制上面扩散模型的生成,这样可以让它生成的时候效率更高一些。同时上面扩散模型的图像质量又能够帮助下面的训练过程,比如β-VAE的误差函数里有一个参数C,它在控制对解耦的影响。原来的工作里C是人为调的,从大到小来设。在我们的方案里,完全由上面扩散模型这一路中间结果来自适应控制,这样生成质量各方面都会更好,解耦性也会更好。

刚才谈了半天,我们对解耦的表达到底是什么形式?可以是前面提到的可解释因素,这是一个很基本的东西,但我们相信更重要的是要结合语言的表达,因为语言描述图像通常就是一个解耦的描述。所以如何用语言的描述表达一个视觉模型,也是一个很基本的思想,我们也正在探索这方面的工作。

比如这幅图像,用大语言模型可以得到一个caption,可能开始比较乱,因为大语言模型本身没有显式解耦能力,只是告诉你有什么东西,我们可以通过后处理得到一个解耦的Text。但是我们现在最大的目的是在视觉表征空间上得到解耦的表征,怎么样去做它?多模态大模型里面有一个对齐问题,如果你能够想办法让文本和视觉表征对齐以后,就会具有一定的意义,而且有对应性。这方面有很多工作可以去做,举个例子,假如它们对齐以后,可以改变文本的属性值,相应视觉表征会改变,相应重建图像属性也会改变。你可以把依此编辑过的图像作为输入,再走一遍,让它改回来,改完以后就应该恢复成原图像,这样就形成一个Loss了。

解耦有一个很大的好处,就是解耦完还可以做组合,生成图像的时候可以组合,不管是在物体层面的组合还是属性组合。如果做好,改变是很容易的,比如我们可以用场景图作为一种解耦表达去控制图像生成,有两只羊还是三只羊,就可以很好地控制它。在这个过程中还可以显式加入Layout过程,两只羊放在哪,每只羊都可以分别控制。这样可以做到最后只改变一只羊的颜色,或者只改变一面墙的颜色,做到更好的可控性。

总结一下,生成式人工智能是新型的生产力和创造力,但是有效利用还存在一些问题,可解释AI的基本理论的发展非常重要,如何真正去做到可解释、可控制的生成,还需要结合我们的先验知识、物理原理等要素。

谢谢大家。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

责任编辑:kj005

文章投诉热线:182 3641 3660 投诉邮箱:7983347 16@qq.com万和引领电热水器行业健康水质新标准,荣获一级健康水质认证

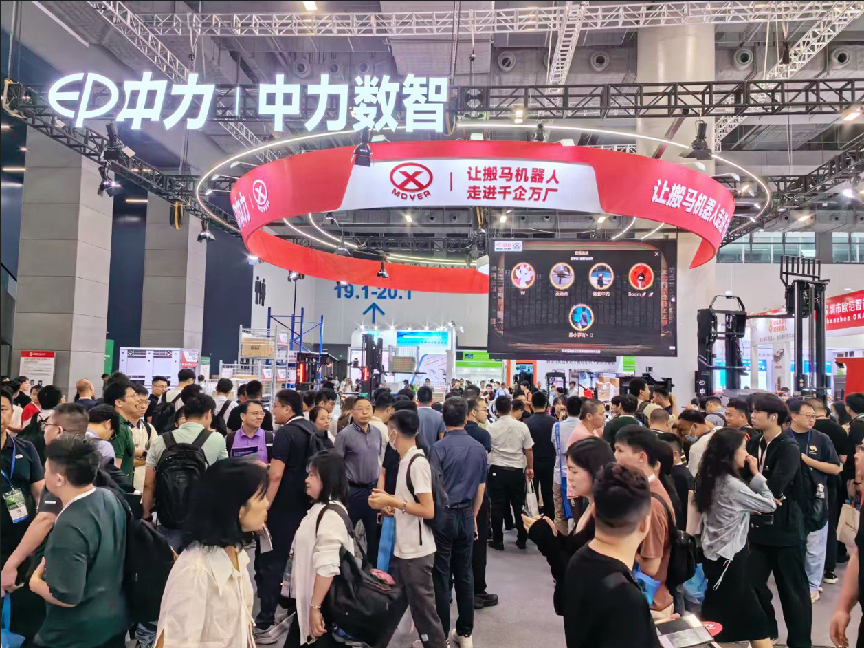

LET探馆│ 打造数智物流的无限可能,中力数智展位全景呈现!

科考研学,北京经开区青少年沉浸式探秘生物多样性奥秘

黑鲨新品引爆2024 ChinaJoy!游戏玩家专属神器,让你征服对手!

北京羽嘉科技“一体化反无人机系统”高原实验圆满成功

香港一带一路研究院特聘研究员向凌云:一带一路倡议拯救了世界

相关新闻

2024 Intersolar Europe,这家中国能源新秀再次瞩目!

6月19日,2024年Intersolar Europe在慕尼黑新国际博览中心盛大开幕。作为全球规模最大、最专业的太阳能...