新研究表明人工智能技术有望媲美专业配音演员

科技日报实习记者 孙明源

影视配音是一项对专业能力要求很高的工作。配音演员需要观看、分析视频中任务的表演,并用适当的韵律(例如重音、语调和节奏)重新录制每一句台词,让配音和画面同步,并且具备丰富的情感和前后一致性,目前的人工智能配音还不能胜任这种工作。然而,近日发表在机器学习和计算神经科学领域顶级会议NeurIPS2021上的一项前沿研究表明,可以媲美专业配音演员的人工智能技术是有望实现的。

论文内容表明,清华大学交叉信息研究院赵行研究组(MARS Lab)联合字节跳动提出了神经网络配音器概念,旨在解决自动视频配音任务。它能够合成与给定视频同步的高质量语音,并利用视频中的嘴部运动来控制生成语音的韵律,以达到语音和视频同步的目的。此外,该工作还针对多说话人场景开发了基于图像的说话人嵌入模块,让神经网络配音器能够根据说话人的面部生成具有合理音色的语音。

“配音的主要应用场景有两个。一是替换拍摄时录制的对话,如拍摄场景下录制的语音音质不佳,又或者出于某种原因演员只是对了口型,声音需要事后配上;二是对译制片进行配音。例如,为了便于中国观众欣赏,将其他语言的视频翻译并配音为中文。我们主要关注的是第一个场景。”在接受科技日报记者采访时,论文的第一作者、清华大学交叉信息研究院博士生胡晨旭解释说。

实验中的定性和定量评估结果都说明,神经网络配音器可以通过视频控制合成语音的韵律,并生成与视频同步的高质量语音。“不过,我们的技术还处于起步阶段,模型需要在真实电影数据上进行训练,也暂时还没有开始中文配音应用。”胡晨旭补充说。

“我们的研究还在继续,请期待我们下一版本的模型。”胡晨旭说。

责任编辑:kj005

文章投诉热线:156 0057 2229 投诉邮箱:29132 36@qq.com关键词:

信源豆豆:帮助军政企赢得保密信息战

2021-12-17 17:25:55信源豆豆:帮助军政企赢得保密信息战

互联网企业向“链”而生 拓展数字化发展空间

2021-12-15 08:50:02互联网企业向“链”而生 拓展数字化发展空间

陀螺科技品牌战略全面升级,定位元宇宙数字产业服务平台

2021-12-14 09:35:23陀螺科技品牌战略全面升级,定位元宇宙数字产业服务平台

我国已经逐渐迈入千兆时代 上海移动5G用户数突破1200万

2021-12-13 09:17:25我国已经逐渐迈入千兆时代 上海移动5G用户数突破1200万

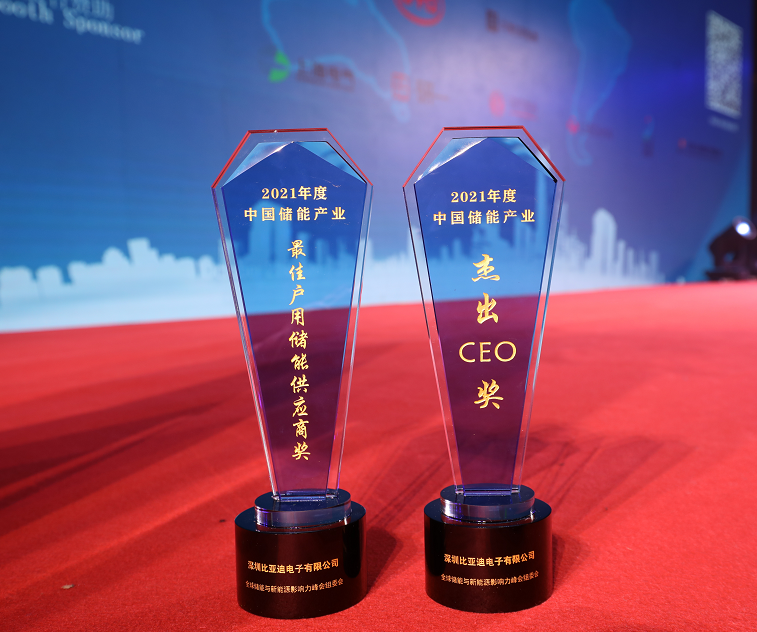

双喜临门!比亚迪喜摘“全球储能与新能源影响力” 峰会两项大奖

2021-12-10 14:56:49双喜临门!比亚迪喜摘“全球储能与新能源影响力” 峰会两项大奖

长征系列运载火箭完成第400次发射!实践六号05组卫星成功发射升空

2021-12-10 10:01:20长征系列运载火箭完成第400次发射!实践六号05组卫星成功发射升空

相关新闻

2021-12-20 18:18:16

2021-12-20 16:48:05

2021-12-20 16:48:03

2021-12-20 16:48:00

2021-12-20 16:47:57

2021-12-20 16:47:55

2021-12-20 16:47:51

2021-12-20 15:17:34

2021-12-20 15:17:31

2021-12-20 15:17:28

最新资讯

2021-12-20 18:18:16

2021-12-20 18:16:29

2021-12-20 18:12:26

2021-12-20 18:15:48

2021-12-20 18:15:41

2021-12-20 18:15:37

2021-12-20 18:15:34

2021-12-20 18:15:30

2021-12-20 18:15:26

2021-12-20 18:15:24

2021-12-20 18:15:23

2021-12-20 18:15:21

2021-12-20 18:15:18

2021-12-20 18:15:14

2021-12-20 18:14:40

2021-12-20 18:14:37

2021-12-20 18:14:33

2021-12-20 18:14:31

2021-12-20 18:14:27

2021-12-20 18:14:24

2021-12-20 18:13:13

2021-12-20 18:13:32

2021-12-20 18:12:39

2021-12-20 18:08:18

2021-12-20 18:11:29

2021-12-20 18:03:15

2021-12-20 18:11:13

2021-12-20 18:10:12

2021-12-20 18:07:48

2021-12-20 17:58:19