打开人工智能“黑盒” 发展可解释、可扩展、可信赖、安全可靠的人工智能

进入21世纪以来,人工智能(Artificial Intelligence,AI)取得了长足发展,已经逐步在自然语言处理、计算机视觉、语音识别、自动驾驶等领域落地。AI与人类紧密的结合,使得智能化的人机协同成为大势所趋。人类在全方位应用AI的同时,更希望能理解、信任、管理AI。因此,发展可解释、可扩展、安全可靠的AI显得至关重要。

而人工智能技术的高速发展也面临诸多困难与挑战。其中,如何把AI技术的基本原理,其自动决策机制,潜在风险及防范措施,以通俗易懂的方式向人类说明,成为发展可信赖,安全可靠人工智能的首要任务。可解释性在我们的日常生活当中比比皆是,比如,一位医生在向一位病人解释诊断结果和治疗措施时,要给病人一个好的病因和治疗解释,让病人放心。而现实情况是,由于核心AI算法,尤其是深度学习算法,通常运行在类似于“黑盒”中的工作模式下,导致AI系统的运行结果,并不能以合乎情理的方式被人类所理解和认同。

深度学习尚存理论与应用缺陷,打造可解释AI势在必行

作为当前人工智能的核心算法之一,深度学习的不可解释性体现在理论和应用两个层面。

在理论层面,有实验证明,给出若干样本图片,被用于训练一个深度神经网络结合逻辑回归的识别模型;该模型能够将绝大部分的正确图片分类,但却会将雪地背景中的哈士奇误判为狼。因为该识别器从训练数据中学到“可以将图片中的大面积白色背景(雪地)作为识别狼的依据”。由于在输入数据和预期结果之间建立(概率)关联是一种虚假关系,当面对与训练样本不一致的情况时,模型的表现就会大失水准。

在应用层面,通过数据驱动得到的AI系统存在一系列隐患,并可能引发严重的社会问题。首先,由于数据样本收集的局限和偏见,导致数据驱动的AI系统也是有偏见的,这种偏见甚至无异于人类社会中的偏见。比如,芝加哥法院使用的犯罪风险评估算法COMPAS 被证明对黑人犯罪嫌疑人造成了系统性歧视,白人更多被错误地评估为具有低犯罪风险,而黑人被错误地评估为具有高犯罪风险,且黑人的概率比白人高出一倍。

其次,“黑盒”似的深度神经网络还常常犯一些十分低级的、人类不可能犯的错误,表现出安全性上的潜在风险。例如,一个深度神经网络原本能够正确识别图片中有一辆校车,但在对少量图片像素做一些人眼不能察觉的改动之后,图片就被识别为鸵鸟。

更有甚者,人们只要戴上一副特制的眼镜,在现实环境中就能够骗过使用深度神经网络的人脸识别系统;考虑到人脸识别系统在金融支付等场景中的广泛应用,这种潜在的金融和社会风险令人不寒而栗。

最后,最重要的是从决策机制来看,当前对深度学习算法的分析还处于不透明的摸索阶段。尤其是拥有亿万个参数的超大规模预训练神经网络,如BERT、GPT3等,其决策过程在学术上仍然没有清晰的说明。这种“黑盒”似的深度神经网络暂时无法获得人类的充分理解与信任,大规模应用此类预训练模型的潜在风险不容忽视。

推动AI持续落地,需满足各类用户对AI可解释性需求

在涉及人身财产安全的重大领域中,如金融、医疗、自动驾驶等,模型的可解释性成了决定用户能否信任模型的关键。针对不同解释受众,模型要获得不同人群的信任,必须要考虑每个人的立场背景、教育程度等因素,提供不同内容与形式的解释。

对于AI 使用者,他们往往是没有相关专业背景的普通人群。他们更关心AI 系统的结果如何影响自身及客户的利益,当出现问题时,需要向他们解释系统做出决策的原因。

例如,某家医院引入一套AI医疗诊断系统。如果该系统给出判断表明病人的癌症检测为阳性,概率为90%,那么这个结论往往是不被接受的。病人会问:你是如何做出这个判断的?根据什么特征和经验?……对于医生等专业人士来说,可能会问:系统做出这种预测,是否符合医院和医管单位的要求?有没有按照正规的医疗程序来做推断?这种推论是否可靠?有多大的风险?这个系统在多少个案例里面被测试过?是不是稳定、可靠、全面、科学的?

再比如,在电商平台中,系统设计者也需要向用户做出解释,帮助人们理解“为什么”算法向他们推荐了某些特定的商品,以此来提高推荐系统的透明度、说服力、有效性、可信赖性和满意度。

对于AI 系统开发者,他们往往是具备专业AI 背景知识的系统开发人员及测试人员,需要准确和深入的专业解释,以便完成对AI 系统的开发调试及测试任务。例如:对于一个大模型来说,是哪一部分的数据对结论起了关键作用?系统的哪一部分被启动?如果发生错误,最大的可能性来自哪里?如何修补?

面对监管红线,AI系统亟须满足各级监管合规要求

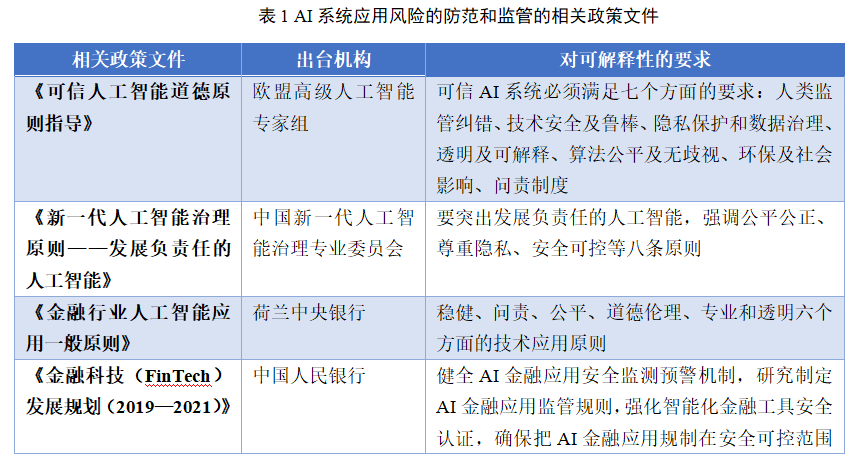

除了技术层面,现行的条例法规同样要求AI系统的开发使用流程必须在监管合规的条件下运行。比如,数据收集及模型学习过程是否符合隐私保护及数据治理条例,必须要有准确无误的解释及认证。而对违反监管要求的智能体行为,也需要有明确的事故分析,为严格的问责机制提供技术说明,如表1所示。

同时,如何将制度层面的规则具体细化落实为可实现的技术方案,仍是可解释AI亟待研究和解决的挑战。

因此,发展可解释AI具有重要的理论意义与现实意义,一方面,可帮助用户建立对AI系统的信任,防止因为算法的黑盒特性做出有偏见的结论,促进算法的公平性;另一方面,可以满足监管机构的合规要求,促进AI向公平性、鲁棒性、安全性发展。

在此背景下,由来自机器学习、计算机视觉、自然语言处理,以及在生物医疗、金融、推荐系统等应用领域的12位著名专家,联合创作了《可解释人工智能导论》一书,现已重磅上市!

本书内容

本书全面介绍可解释AI的基础知识、理论方法和行业应用。全书分为三部分,共11 章。

第1章揭示基于数据驱动的人工智能系统决策机制,提出一种基于人机沟通交互场景的可解释人工智能范式。

第2~5 章介绍各种可解释人工智能技术方法,包括贝叶斯方法、基于因果启发的稳定学习和反事实推理、基于与或图模型的人机协作解释、对深度神经网络的解释。

第6~10 章分别介绍可解释人工智能在生物医疗、金融、计算机视觉、自然语言处理、推荐系统等领域的应用案例,详细说明可解释性在司法、城市管理、安防和制造等实际应用中发挥的积极作用。

第11 章对全书进行总结,并论述可解释人工智能研究面临的挑战和未来发展趋势。

作者介绍

杨强

加拿大工程院及加拿大皇家科学院两院院士,香港科技大学讲席教授,AAAI 2021 大会主席,中国人工智能学会(CAAI)荣誉副理事长,香港人工智能与机器人学会(HKSAIR)理事长以及智能投研技术联盟(ITL)主席。他是AAAI/ACM/CAAI/IEEE/IAPR/AAAS Fellow,也是IEEE Transactions on Big Data 和ACM Transactions on Intelligent Systems and Technology 创始主编,以及多个国际人工智能和数据挖掘领域杂志编委。曾获2019 年度“吴文俊人工智能科学技术奖”杰出贡献奖,2017 年ACM SIGKDD 杰出服务奖。杨强毕业于北京大学,于1989 年在马里兰大学获得计算机博士学位,之后在加拿大滑铁卢大学和Simon Fraser 大学任教,他的研究领域包括人工智能、数据挖掘和机器学习等。他曾任华为诺亚方舟实验室主任,第四范式公司联合创始人,香港科技大学计算机与工程系系主任以及国际人工智能联合会(IJCAI)理事会主席。领衔全球迁移学习和联邦学习研究及应用,最近的著作有《迁移学习》《联邦学习》《联邦学习实战》《隐私计算》等。

范力欣

微众银行人工智能首席科学家,研究领域包括机器学习和深度学习、计算机视觉和模式识别、图像和视频处理等。他曾在诺基亚研究中心和欧洲施乐研究中心工作,是70多篇国际期刊和会议文章的作者。他长期参加NIPS/NeurIPS、ICML、CVPR、ICCV、ECCV、IJCAI 等顶级人工智能会议,并主持举办了各个技术领域的研讨会。他还是在美国、欧洲和中国提交的百余项专利的发明人,以及IEEE 可解释人工智能标准制定组主席。

朱军

清华大学计算机系教授、人智所所长、北京智源人工智能研究院和瑞莱智慧首席科学家,曾任卡内基梅隆大学兼职教授。主要从事机器学习研究,在国际顶级会议期刊发表论文百余篇;受邀担任IEEE TPAMI 的副主编(大陆首次)、AI 编委,担任ICML、NeurIPS 等领域主席20 余次。获科学探索奖、CCF 自然科学一等奖等,MIT TR35 中国先锋者以及IEEE“AI’s 10 to Watch”,带领团队研制“珠算”深度概率编程库、“天授”强化学习库和RealSafe 对抗攻防平台,获多项国际竞赛冠军和最佳论文奖。

陈一昕

华夏基金董事总经理,首席数据官兼首席技术官。中国科学技术大学少年班本科,美国伊利诺大学香槟分校计算机博士,美国华盛顿大学计算机系正教授、终身教授,大数据科学中心创始主任,研究领域为金融科技、金融数据挖掘、智能投资顾问、机器学习、优化算法、人工智能和云计算等。拥有15 年以上的前沿性研究、管理大型研发团队、开发商业产品的丰富经验。

张拳石

上海交通大学约翰·霍普克罗夫特计算机科学中心长聘教轨副教授,博士生导师,入选国家级海外高层次人才引进计划,获ACM China 新星奖。他于2014 年获得日本东京大学博士学位,于2014–2018 年在加州大学洛杉矶分校(UCLA)从事博士后研究,主要研究方向包括机器学习和计算机视觉。其研究工作主要发表在计算机视觉、人工智能、机器学习等不同领域的顶级期刊和会议上,包括IEEE T-PAMI、ICML、ICLR、CVPR、ICCV、AAAI、KDD、ICRA 等。近年来,他在神经网络可解释性方向取得了多项具有国际影响力的创新性成果。他承担了ICPR 2020 的领域主席,CCF-A 类会议IJCAI 2020 和IJCAI 2021 的可解释性方向的Tutorial,并先后担任了AAAI 2019、CVPR 2019、ICML 2021 大会可解释性方向的分论坛主席。

朱松纯

1991 年毕业于中国科学技术大学,1996 年获美国哈佛大学计算机博士学位,师从国际数学大师大卫·曼福德教授,在国际顶级期刊和会议上发表论文300 余篇,三次问鼎计算机视觉领域国际最高奖项——马尔奖,两次担任国际计算机视觉与模式识别大会主席。在1990 年代率先将概率统计建模与随机计算方法引入计算机视觉研究,提出了一系列图像与视频的结构化解译的框架、数理模型和统计算法,发展了广义模式理论(General Pattern Theory),在视觉常识推理、场景理解等认知科学领域做出了重要贡献。自2010 年以来,两次担任美国视觉、认知科学、AI 领域跨学科合作项目MURI 负责人[Principal Investigator]。在科研方面具有很强的前瞻性,选题和方法独树一帜,长期致力于构建计算机视觉、认知科学,乃至人工智能科学的统一数理框架。

2002 年加盟美国洛杉矶加州大学(UCLA)任教,任统计系与计算机系教授,计算机视觉、认知、学习与自主机器人中心主任。2020 年9 月回国筹建北京通用人工智能研究院(Beijing Institute for General Artificial Intelligence),同时担任清华大学与北京大学讲席教授,并任北京大学人工智能研究院院长、清华大学通用人工智能研究院(筹)院长。2021 年4 月,北京大学与清华大学联手建立通用人工智能实验班,均由朱松纯领衔。

陶大程

京东集团副总裁、京东探索研究院院长,兼任清华大学卓越访问教授、中国科学技术大学大师讲席教授。加入京东前,在悉尼大学担任澳大利亚桂冠教授、Peter Nicol Russell 讲习教授、悉尼大学人工智能中心主任。主要从事可信人工智能领域的研究,在权威杂志和重要会议上发表了200余篇论文;论文被引用近6 万次,h-index 为126,并多次荣获顶级国际会议最佳论文奖、时间检验奖。2015 年获得澳大利亚尤里卡奖和悉尼科技大学校长奖章,2018 年获得IEEE ICDM 研究贡献奖,2020 年再度荣获澳大利亚尤里卡奖和悉尼大学校长研究贡献奖,2021 年荣获IEEE 计算机协会Edward J McCluskey 技术成就奖。先后当选IEEE/AAAS/ACM Fellow、欧洲科学院外籍院士、新南威尔士皇家学院院士及澳大利亚科学院院士。

崔鹏

清华大学计算机系长聘副教授,博士生导师。研究兴趣聚焦于大数据驱动的因果推理和稳定预测、大规模网络表征学习等。在数据挖掘及人工智能领域顶级国际会议发表论文100 余篇,先后五次获得顶级国际会议或期刊论文奖,并先后两次入选数据挖掘领域顶级国际会议KDD 最佳论文专刊。担任IEEE TKDE、ACM TOMM、ACM TIST、IEEE TBD 等国际顶级期刊编委。曾获得国家自然科学二等奖、教育部自然科学一等奖、CCF-IEEE CS 青年科学家奖、ACM 杰出科学家。

周少华

博士,致力于医学影像的研究创新及其应用落地。Fellow of IEEE、AIMBE(美国医学与生物工程院)、NAI(美国国家学术发明院)。现任中国科学技术大学讲席教授、生物医学工程学院执行院长、影像智能与机器人研究中心(筹)主任、中科院计算所客座研究员、香港中文大学(深圳)客座教授,曾在西门子医疗研究院任职首席影像AI 专家。他已经编撰了5 本学术专著,发表了240 余篇学术期刊及会议论文,并拥有140 余项授权专利。他多次因其学术成就和创新贡献而获奖,包括发明奥斯卡奖、西门子年度发明家、马里兰大学ECE 杰出校友、MICCAI 年轻科学家奖提名文章等。他热心奉献于专业社区,是行业顶级协会MICCAI 财长兼理事、Medical Open Network for AI(MONAI)咨询顾问、顶级期刊Medical Image Analysis、IEEE Trans. Pattern Analysis and Machine Intelligence(TPAMI)、IEEE Trans.Medical Imaging(TMI)等编委、顶级会议AAAI、CVPR、ICCV、MICCAI 和NeurIPS 等领域主席、MICCAI2020 的程序联席主席、“视觉求索”公众号联席主编。

刘琦

同济大学生命科学与技术学院生物信息系长聘教授,博士生导师。长期致力于发展人工智能和生物组学交叉融合的研究范式,面向肿瘤精准用药、药物发现、肿瘤免疫治疗及基因编辑领域开发新的计算方法学和计算平台,推进人工智能和组学数据分析的结合及临床应用。在Nature Communications、Science Advances、Genome Biology 等发表学术论文,受邀在Cell Trends 系列杂志等发表综述和评述论文。主持国家863 基金及国家自然科学基金,国家重点研发计划BT&IT 专项子课题,参与国家重点研发计划精准医学及慢病专项等。任ELSEVIER 出版社人工智能生命科学交叉领域杂志Artificial Intelligence in the Life Sciences 编委。其研究团队和国际制药企业、CRO 公司及互联网公司开展紧密合作,推动了人工智能技术在生物医学领域的应用。其在人工智能和生物组学交叉领域的研究工作先后入选2019 年、2020 年中国生物信息学研究十大进展,曾获吴文俊人工智能自然科学技术奖三等奖、药明康德生命化学奖、华夏医学奖三等奖、中国发明协会发明创新奖二等奖等。先后入选上海市浦江人才、启明星人才、曙光人才,入选教育部“青年长江学者”。

黄萱菁

复旦大学计算机科学技术学院教授、博士生导师。1998 年于复旦大学获计算机理学博士学位,研究领域为人工智能、自然语言处理、信息检索和社会媒体分析。兼任中国中文信息学会理事、社会媒体专委会副主任,中国计算机学会自然语言处理专委会副主任、学术工作委员会委员、AACL执行委员。在高水平国际学术期刊和会议上发表了百余篇论文,负责的多个科研项目得到国家自然科学基金、科技部、教育部、上海市科委的支持。担任2015 年社会媒体处理大会程序委员会副主席,2016 年、2019年全国计算语言学会议程序委员会副主席,2017 年国际自然语言处理与中文计算会议程序委员会主席,2020 年国际自然语言处理与中文计算会议大会主席,2021 年EMNLP 自然语言处理实证方法国际会议程序委员会主席等学术职务。获2021 年上海市育才奖,并入选由清华—中国工程院知识智能联合研究中心和清华大学人工智能研究院联合发布的“2020 年度人工智能全球女性”“2020 年度AI 2000 人工智能全球最具影响力提名学者”“福布斯中国2020 科技女性榜”。

张永锋

罗格斯大学计算机系助理教授、博士生导师,互联网智能与经济实验室主任。在清华大学获计算机科学学士和博士学位,曾于马萨诸塞大学阿默斯特分校任博士后研究员,并于新加坡国立大学、加州大学圣克鲁兹分校访学。研究兴趣包括机器学习、数据挖掘、信息检索、推荐系统、互联网经济、人工智能的可解释性与公平性、人工智能伦理等。研究成果发表于SIGIR、WWW、RecSys、ACL、NAACL、CIKM、WSDM、AAAI、IJCAI、TOIS 等领域内的主要会议或期刊。担任期刊ACM Transactionson Information Systems、ACM Transactions on Recommender Systems、Frontiersin Big Data 副主编。曾获得中国人工智能学会优秀博士学位论文奖、AIRS 最佳论文奖、RecSys 最佳论文提名、ACM TOIS 杰出编辑奖、罗格斯大学计算机系最佳教学奖、美国自然科学基金杰出青年奖(NSF CAREER Award)。

本书特点

领域名家扛鼎之作。本书汇集了人工智能领域的著名学者,研究成果卓著,本书正是诸位专家数年研究成果的扛鼎之作。

系统全面自成一体。本书讨论了可解释AI 的目的、定义、范畴、面临的挑战及未来发展方向,特别是本书多角度论述了可解释AI 的不足,并提出了基于人机交互沟通的可解释AI 范式。

知识完备循序渐进。作为一本导论性质的介绍图书,本书内容深入浅出,从基础的人工智能的可解释性概念层面展开讨论,先帮助读者建立对可解释AI 的直观、形象的理解,再介绍可解释AI 的前沿方法,最后通过一系列丰富的行业应用案例,巩固读者对书中所介绍的可解释AI 技术的理解,从而完成对可解释AI领域循序渐进的介绍。

理论实践价值兼备。本书系统地论述了可解释AI 的理论发展现状,并按照五种分类介绍了解释性方法,即可解释图模型、贝叶斯深度学习模型、基于知识图谱的可解释模型、基于可解释性的交流学习、对神经网络的解释。同时,本书从介绍了可解释性方法在医疗、金融、视觉、自然语言处理、推荐系统等方面的应用角度出发,明确指出在各种场景下解释所要达到的具体目标。

应用案例翔实丰富。本书从分析对可解释AI 的实际需求出发,深入及时地介绍前沿方法。全书共有15个应用案例,分别包括:基因编辑和医学影像处理,金融量化投资和信用违约预测,模型安全、视觉问答和知识发现,对话系统、智能问答、情感分析和自动文摘,电子商务、社交网站、基于位置的服务和多媒体系统。不同行业的产业从业者,都可以从中了解可解释AI的落地方法。

内容实用覆盖面广。本书覆盖人群广泛,对于入门读者,本书对可解释AI 前沿技术及时归纳梳理,并深入浅出地介绍;对于资深的研究者,本书也给出了进阶的研究路径;对于行业应用者,本书提出了选择不同解决方案的依据。同时,本书也照顾到关注人工智能应用及具有社会影响力的人士,包括政策制定者、法律工作者和社会科学研究人士。

配套资源丰富齐全。本书配备丰富的学习资料,包括配套PPT、可解释AI 相关的开源资源、中英术语对照、索引和全书的参考文献,供读者进一步查阅学习。

专家力荐

本书全面介绍了可解释人工智能在理论上和应用上的发展现状、存在的问题,以及今后发展的方向,对于想了解人工智能和有意献身人工智能事业的研究者、开发者、决策者和使用者来讲,都是一部很好的参考书。

张钹

中国科学院院士,清华大学人工智能研究院院长

杨强教授领衔撰写的这本可解释人工智能专著,系统性地总结了对于机器学习本质的深度理解和探索,提出了一种面向人机协作的交互式可解释人工智能范式。本书通过计算机视觉、自然语言处理、推荐系统等技术领域,以及生物医疗和电商金融等应用领域的实际案例,展示了可解释人工智能对提升公众信任及满足监管需求的积极作用。我相信各行各业关心人工智能发展的读者,包括高校计算机及人工智能专业的老师和同学等,都可以从这本专著中发现各种有益的论述和有趣的观点。

沈向洋

微软前全球执行副总裁,美国国家工程院外籍院士,英国皇家工程院外籍院士

可解释人工智能是一个颇受关注的重要论题,但其内涵和外延的很多方面还缺乏共识。杨强教授领衔撰写的这本书对可解释人工智能进行了生动的探讨,尤其是给出了多个应用领域案例。即便是缺乏相关专业知识的读者,阅读后也能有所收获。

周志华

南京大学人工智能学院院长, ACM/AAAI Fellow

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。

责任编辑:kj005

文章投诉热线:156 0057 2229 投诉邮箱:29132 36@qq.com